OptiTech har påbörjat lansera ett banbrytande tekniskt ramverk för att analysera och stresstesta LLM:er samt RAG‑baserade dialogsystem i verklighetsnära, dynamiska miljöer.

Initiativet markerar ett avgörande steg i att förstå hur avancerade AI-system agerar under förhållanden präglade av osäkerhet, kontextskiften och semantisk erosion – situationer som speglar den verkliga användningen av AI i kundservice, livechattar och sociala gränssnitt.

Utmaningen: Från laboratorier till verklighet

LLM:er har på kort tid omdefinierat hur människor interagerar med teknik. Men trots deras höga precision i kontrollerade testmiljöer visar många modeller tydliga brister i scenarier där samtal pågår länge, kontext förändras gradvis och användaren varierar sitt språk, tonläge och intention. Det är i dessa miljöer modellernas sanna intelligens och robusthet prövas – inte bara initialt, utan genom hela konversationens livslängd.

Samtidigt saknar dagens benchmarkverktyg ofta mekanismer för att fånga detta. De fokuserar huvudsakligen på isolerade uppgifter inom logik eller faktainhämtning. Vad som hittills har saknats är ett verktyg för att mäta hur språkmodeller presterar i det OptiTech definierar som kognitiv turbulens – när semantiken glider, uppgifter krockar, och användarens beteende skiftar.

Teknisk arkitektur och innovationspunkter

OptiTechs nya ramverk introducerar flera avgörande komponenter:

-

Långformsdialoger (100–300 turer): Modellernas hållbarhet över långa och komplexa konversationskedjor testas med växlande uppgifter, språktoner och mål.

-

Multidimensionella stresstester: Scenarier med avsiktliga semantiska störningar, vilseledande återkoppling, meta-kommandon och verktygsanrop.

-

Mätning av kontextuell integritet: Nya metoder som mäter hur väl modellen bevarar referenser, tolkar implicita förändringar och bibehåller samtalslogik.

-

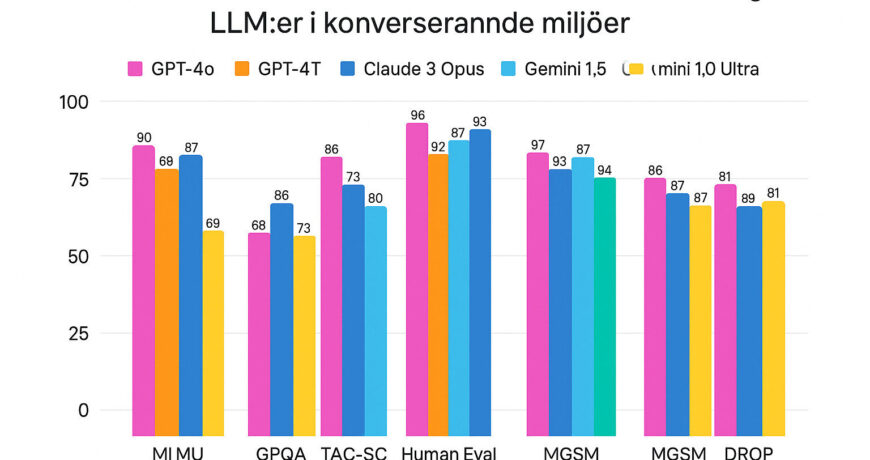

Modelljämförbarhet: Benchmarkdesign som möjliggör direkt jämförelse mellan ledande modeller som GPT‑4, Claude, LLaMA, Mistral samt verktygsförstärkta agenter.

Dataseten omfattar konversationstyper inom kundsupport, teknisk felsökning, utbildning, medicinsk rådgivning och stresspåverkad samarbetsdialog – alla kontexter där robusthet är avgörande.

Vi behöver utvärdera LLM:er på deras verkliga styrkor – inte bara i teoretiska testmiljöer, utan i samtal som speglar livet och dess komplexitet. Vår ambition är att skapa ett ramverk som inte bara mäter intelligens, utan mäter tålighet, anpassning och hållbar semantisk koherens,

Sara Kihlberg, AI-strateg och projektledare på OptiTech

Projektet påbörjas idag, och utvecklingen leds av ett tvärfunktionellt team av AI-ingenjörer, forskare inom människa–datorinteraktion och experter på språkmodellanalys. Arbetet sker i nära samverkan med universitet, AI-labb och etiska råd för att säkerställa både teknisk stringens och samhällsnytta.

Ramverket är planerat att färdigställas och lanseras som första version under 2026. Den långsiktiga visionen är att etablera det som en öppen industristandard – ett referensverktyg för alla som bygger, testar eller distribuerar konverserande AI-lösningar.

Utöver det tekniska ramverket kommer OptiTech att publicera löpande vitböcker, analysrapporter och öppna dataset kopplade till testmiljöerna. Syftet är att möjliggöra oberoende jämförelser och att främja ett mer transparent och robust AI-ekosystem.